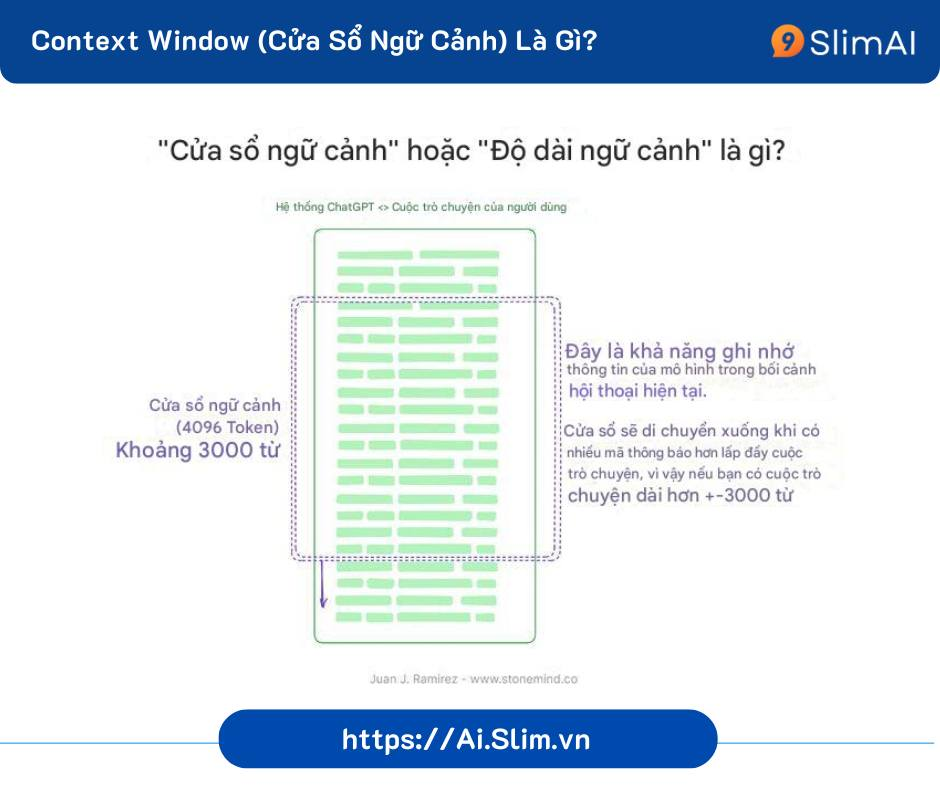

Context Window là giới hạn số lượng thông tin (token) mà ChatGPT hoặc các mô hình AI có thể "ghi nhớ" và xử lý trong một lần

Vai trò của Context Window khi dùng AI

- Duy trì ngữ cảnh hội thoại: Giúp AI hiểu và trả lời chính xác dựa trên các câu hỏi trước đó.

- Phân tích tài liệu dài: Cho phép mô hình xử lý văn bản hoặc dữ liệu lớn trong phạm vi cho phép.

- Cá nhân hóa phản hồi: Giữ được thông tin quan trọng của người dùng trong các lần trao đổi gần

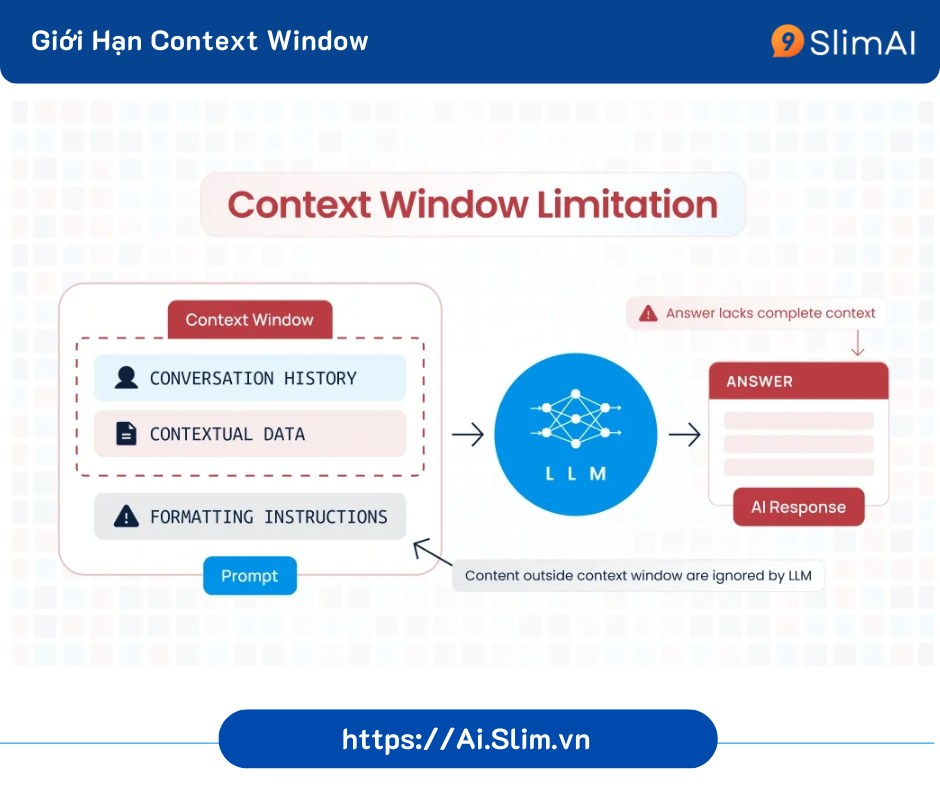

Khi nào bị vượt giới hạn Context Window?

- Khi lượng thông tin đưa vào (hội thoại, tài liệu) vượt quá giới hạn token của mô hình.

- Ví dụ: Bạn hỏi nhiều câu liên tục trong một hội thoại. Sau rất nhiều câu hỏi, tổng số token tích lũy vượt qua giới hạn token.

Hậu quả khi vượt giới hạn

- Mất ngữ cảnh: AI quên thông tin quan trọng, trả lời không chính xác

- Phân tích sai lệch: Kết quả bị thiếu sót do không xử lý toàn bộ dữ liệu.

- Tăng chi phí xử lý: Phải chia nhỏ dữ liệu hoặc yêu cầu tóm tắt nhiều lần.

Giới hạn của các mô hình AI

- GPT-4o: 128.000 token ~ 102.400 từ Tiếng Việt

- Claude 3: 200.000 token ~ 160.000 từ

- Gemini 1.5 Pro: 2.000.000 token ~ 1.600.000 từ

Cách khắc phục khi vượt giới hạn Context Window:

- Tóm tắt hội thoại cũ: Yêu cầu ChatGPT tóm tắt nội dung chính

- Chia nhỏ yêu cầu: Xử lý từng phần nhỏ, sau đó ghép kết quả

- Cung cấp ngữ cảnh ngắn gọn: Chỉ gửi thông tin liên quan

- Loại bỏ nội dung không cần thiết

Hy vọng bài viết có thể giúp các bạn hiểu tận gốc, nắm chắc mọi khía cạnh của AI